Dlaczego moja strona nagle spadła w wynikach Google? To jedno z tych pytań, które potrafi zepsuć dzień właścicielowi serwisu, marketerowi i developerowi jednocześnie. Kiedy wykresy w Search Console i Analyticsie zaczynają nurkować, łatwo wpaść w panikę. Zamiast tego warto działać metodycznie: zrozumieć możliwe przyczyny, szybko zdiagnozować problem i wdrożyć plan naprawczy. Poniżej znajdziesz klarowny przewodnik, który pomoże Ci przejść przez ten proces krok po kroku — bez mitów i skrótów myślowych, za to z naciskiem na praktykę i priorytety.

Co naprawdę się wydarzyło?

Najczęściej to zbieżność kilku czynników, a nie jeden „zły” update czy link.

Spadki rzadko mają jedną przyczynę. Czasem nakładają się: aktualizacja algorytmu, zmiany na stronie, problem techniczny, ruch konkurencji i sezonowość. Kluczem jest odróżnienie spadku względnego (konkurenci wyprzedzili) od absolutnego (Google gorzej ocenia Twoją stronę). To pozwala ustawić właściwe priorytety i nie marnować czasu na ślepe testy.

Najczęstsze powody, przez które strona spadła w wynikach Google

Metodycznie sprawdź te obszary — zwykle winowajca jest w jednym z nich.

Aktualizacje algorytmu i zmiana krajobrazu SERP

Core Updates i tematyczne update’y potrafią przestawić akcenty jakości, intencji i autorytetu.

- Aktualizacje rdzeniowe (Core) rewidują to, co Google rozumie jako „najlepszą odpowiedź” dla danej intencji. Strony, które były „wystarczające”, nagle stają się przeciętne.

- Update’y tematyczne (np. spam, linki, recenzje produktów) uderzają w konkretne praktyki i branże.

- Zmiany w SERP (więcej map, wideo, People Also Ask, fragmenty z AI) mogą „zabrać” kliknięcia, nawet gdy pozycje nominalnie się nie zmieniły.

Co robić: Porównaj datę spadku z historią aktualizacji i sprawdź, czy Twoje treści dalej idealnie trafiają w intencję zapytania (np. poradnik vs. lista narzędzi vs. porównanie).

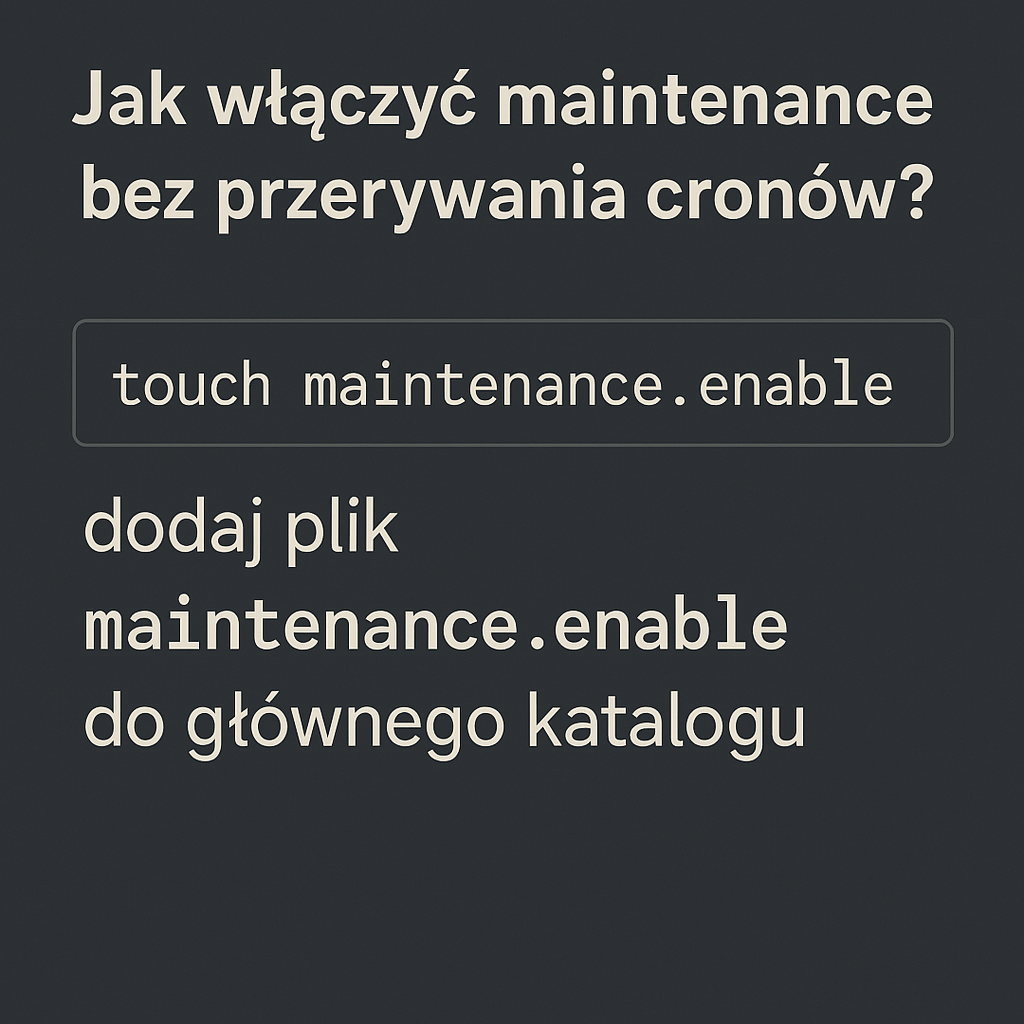

Zmiany techniczne, migracje i błędy wdrożeń

Jeden checkbox „noindex”, błędna reguła w robots.txt albo canonical i pozycje lecą.

- Przypadkowe noindex na szablonie, blokada w robots.txt, znikające mapy witryny, błędne kanonikale.

- Migrations: zmiany URL-i bez pełnych 301, zamiana http→https bez przekierowań, nowe struktury menu i wewnętrznego linkowania.

- Problemy z renderowaniem JS, utrata treści przy SSR/CSR, brak krytycznych elementów na mobile.

Co robić: URL Inspection w Search Console, przegląd robots.txt i meta robots, walidacja przekierowań, snapshoty strony w wersji z cache i „Wyświetl źródło”.

Problemy z indeksacją i crawl budgetem

Gdy Google nie widzi lub nie indeksuje poprawnie treści, widoczność gaśnie.

- Duży wzrost błędów 404/5xx, duplikacja tagów i paginacji, nieaktualne mapy witryny.

- Zbyt dużo „thin content” rozmywa jakość całej witryny.

- Przypadkowe usunięcie ważnych adresów z indeksu podczas porządków.

Co robić: Raport „Indeksowanie” w GSC, stan mapy witryny, przegląd logów serwera (jeśli masz dostęp), uporządkowanie duplikatów i kanonikali.

Spadek lub utrata jakości linków

Linki wciąż są sygnałem — ich stopniowa utrata lub deprecjacja boli.

- Naturalny zanik linków (zmiany na cudzych stronach, wygasłe domeny).

- Deprecjacja niskiej jakości linków po update’ach antyspamowych.

- Błędnie użyty disavow, który odciął wartościowe odnośniki.

Co robić: Audyt profilu linków w kilku narzędziach, analiza dynamiki przyrostu/zaniku, odzyskiwanie utraconych linków, porównanie z konkurencją.

Treści nie trafiają już w intencję lub są słabsze niż u konkurencji

Google preferuje treści kompletne, aktualne i użyteczne „tu i teraz”.

- Teksty nieaktualne, brak danych, brak odpowiedzi na nowe pytania użytkowników.

- Zbyt ogólne treści vs. konkurenci z twardymi danymi, case studies, schematami, wideo.

- Brak E-E-A-T: autor bez ekspertyzy, brak źródeł, brak sekcji „O nas”, słabe sygnały zaufania.

Co robić: Aktualizacje merytoryczne, uzupełnianie luk, dodanie unikalnych danych, wzmocnienie E-E-A-T (autorzy, źródła, recenzje, polityki).

Sezonowość i zmiana popytu

Nie każdy spadek to „kara”. Czasem rynek po prostu zmalał.

- Branże sezonowe (turystyka, moda, prezenty) z naturalnymi wahaniami.

- Zmiany trendów i zapytań (nowe frazy, nowe formaty, np. shorty, porównania).

Co robić: Porównuj rok do roku, używaj Google Trends i Search Console (zapytania), dostosuj kalendarz treści.

Bezpieczeństwo i ręczne działania

Zhackowana strona, malware lub naruszenie wytycznych może wyłączyć widoczność niemal z dnia na dzień.

- Ostrzeżenia o złośliwym oprogramowaniu, phishing, treści wstrzyknięte przez atak.

- Manual actions za spam, cloaking, sztuczne linki.

Co robić: Sprawdź „Ręczne działania” i „Problemy dotyczące bezpieczeństwa” w GSC, natychmiast oczyść witrynę, zgłoś prośbę o ponowne rozpatrzenie.

Jak zdiagnozować przyczynę w 60 minut

Szybki audyt, który separuje objawy od źródła problemu.

-

Zaznacz datę spadku i porównaj wykresy w GSC (wydajność) i GA4 (organiczne sesje).

-

Sprawdź raport „Indeksowanie” oraz „Strony” w GSC — czy rośnie liczba błędów, spada liczba zindeksowanych adresów?

-

Wejdź w „Ręczne działania” i „Problemy dotyczące bezpieczeństwa”.

-

Użyj URL Inspection na 3–5 kluczowych podstronach: czy Google je widzi? Jak je renderuje? Czy są kanonikalizowane do siebie?

-

Przejrzyj robots.txt, meta robots, nagłówki HTTP, mapę witryny. Szukaj noindex, disallow, błędnych kanonikali.

-

Sprawdź uptime i 5xx w hostingu/logach. Krótkie, powtarzalne awarie potrafią mocno odbić się na widoczności.

-

Porównaj treść topowych stron z konkurencją: aktualność, zakres, dane, multimedia, odpowiedzi na „People Also Ask”.

-

Zajrzyj do narzędzia do linków: duże spadki referring domains? Ważne linki wygasły?

-

Sprawdź Core Web Vitals i szybkość na mobile — szczególnie LCP i INP. Problemy wydajnościowe po wdrożeniu poprawek mogą zbiegć się ze spadkiem.

-

Zmapuj ostatnie wdrożenia: zmiany w motywie, wtyczkach, strukturze URL, menu, linkowaniu wewnętrznym. Często „winna” jest ostatnia publikacja lub aktualizacja.

Jak podnieść stronę po tym, jak spadła w wynikach Google

Priorytety naprawy: najpierw krytyczne błędy, potem jakość treści i sygnały zaufania.

-

Napraw krytyczne blokery indeksacji: usuń noindex, popraw robots.txt, napraw mapy witryny, ustaw poprawne 301.

-

Ogarnij technikalia: błędy 404/5xx, kanonikalizacja, duplikacja, paginacja, hreflang (jeśli dotyczy), Core Web Vitals, responsywność.

-

Wyrównaj intencję: zrób gap analysis względem top 3 konkurentów. Dodaj sekcje, których brakuje, uzupełnij dowody (screeny, dane, źródła), popraw “above the fold”.

-

Wzmocnij E-E-A-T: biogramy autorów z dorobkiem, polityka edycji i źródeł, opinie klientów, referencje, case studies, wyraźne dane kontaktowe i informacje o firmie.

-

Uporządkuj architekturę informacji: lepsze menu, breadcrumbs, linkowanie kontekstowe do kluczowych filarów tematycznych.

-

Zadbaj o linki: odzyskaj utracone odnośniki, opracuj działania PR/digital PR, twórz treści, do których naturalnie linkują (badania, raporty, narzędzia).

-

Aktualizuj stale zielone treści (evergreen): podmieniaj nieaktualne screeny, dane, daty, porównania. Dodaj FAQ odpowiadające na nowe pytania użytkowników.

-

Poproś o ponowne zaindeksowanie w GSC dla kluczowych podstron po istotnych zmianach.

Ile to potrwa? Realne oczekiwania co do czasu powrotu

Od kilku dni do kilku miesięcy — zależnie od skali problemu i tempa crawl/indeksacji.

- Błędy techniczne po naprawie mogą „odpuścić” w ciągu 3–14 dni.

- Rewizja treści i dopasowanie do intencji zwykle pokazują efekty po kolejnych cyklach crawl i recenzji jakości — często 4–8 tygodni.

- Zmiany po Core Update’ach mogą wymagać czekania na kolejne większe odświeżenie sygnałów.

- Budowa autorytetu (E-E-A-T, linki) to proces na 2–6 miesięcy i więcej.

Ważne: stabilizacja bywa falująca — po naprawach możesz widzieć skoki i cofki, zanim krzywa się wypłaszczy.

Czego unikać po spadku

Te działania zwykle pogarszają sytuację zamiast pomagać.

- Masowe zmiany wszystkiego naraz — utrudniają diagnozę i mogą wprowadzić nowe błędy.

- Kupowanie pakietów linków „na już” — ryzyko filtrów i długotrwałych szkód.

- Usuwanie połowy treści bez planu — utrata topical authority i linków wewnętrznych.

- Nerwowe zmiany tytułów/meta co kilka dni — sygnały niestabilności bez zysku dla użytkownika.

- Ignorowanie mobile — większość oceny odbywa się w indeksie mobilnym.

Sekcja kontrolna: kiedy strona spadła w wynikach Google, zrób to od ręki

Krótka checklista do przypięcia nad biurkiem.

- Sprawdź „Ręczne działania” i bezpieczeństwo w GSC.

- Zrób URL Inspection dla 3 kluczowych stron.

- Przejrzyj robots.txt, meta robots, sitemap, kanonikale.

- Zmapuj ostatnie wdrożenia i cofnij potencjalnie szkodliwe.

- Oceń dopasowanie treści do intencji i uzupełnij braki.

- Napraw błędy 5xx/404 i problemy z CWV.

- Skontroluj profil linków i odzyskaj utracone odnośniki.

- Zgłoś do ponownej indeksacji kluczowe URL-e.

Podsumowanie

Spadek widoczności to sygnał, nie wyrok. Najlepszą strategią jest szybka, spokojna diagnoza i praca od podstaw: technikalia, intencja, jakość, zaufanie. Jeśli zrobisz to metodycznie, odzyskasz pozycje — a często wyjdziesz z kryzysu z lepszym, szybszym i bardziej użytecznym serwisem niż wcześniej. Pamiętaj: Google premiuje te strony, które konsekwentnie pomagają użytkownikom. Zadbaj o to każdego dnia, a update’y przestaną być straszne, bo będą działały na Twoją korzyść.