Wprowadzenie i kontekst

Redis/Memcached to dwa najpopularniejsze silniki pamięci podręcznej, które potrafią radykalnie przyspieszyć aplikacje webowe, odciążając bazę danych i serwer aplikacyjny. Umiejętne cache’owanie zapytań i sesji potrafi skrócić czas odpowiedzi nawet kilkukrotnie, ograniczyć koszty infrastruktury i poprawić stabilność systemu podczas pików ruchu. Poniżej znajdziesz praktyczny, techniczny przewodnik: kiedy użyć którego narzędzia, jak je zainstalować, skonfigurować i bezpiecznie wdrożyć w środowisku produkcyjnym. Bez wodolejstwa — konkretne kroki, dobre praktyki i gotowe ustawienia, które możesz skopiować do projektu.

Dlaczego cache’ować zapytania i sesje

Cache zmniejsza liczbę kosztownych operacji na bazie danych i skraca czas generowania odpowiedzi. Przy wynikach, które nie zmieniają się co milisekundę (np. listy produktów, wyniki filtrów, widoki profilów), pamięć podręczna potrafi wyeliminować setki zapytań na sekundę.

Sesje użytkowników to z kolei stan logowania i koszyk — zapisany poza procesem aplikacji zyskuje na niezawodności i skalowalności. Trzymanie sesji w Redis lub Memcached ułatwia skalowanie poziome (więcej instancji aplikacji bez lepienia się do sticky sessions).

Redis/Memcached: szybkie porównanie

-

Redis: bogate typy danych (string, hash, list, set, sorted set), skrypty Lua, pub/sub, strumienie, TTL per klucz, klastrowanie, opcjonalna trwałość (RDB/AOF). Świetny do sesji i cache’u wymagającego atomowych operacji, rate limiting, kolejek.

-

Memcached: prostota, ultra szybkie klucze-wartości, konsystentna rozproszona pamięć, brak trwałości i wyrafinowanych typów. Idealny do prostego cache’u odczytowego, kiedy liczy się czysta szybkość i minimalny narzut.

-

Pamiętaj: jeśli sesje to krytyczne dane i nie chcesz ich tracić przy restarcie, Redis z trwałością będzie lepszym wyborem. Do samego cache’u wyników zapytań, które można odtworzyć — Memcached bywa lżejszy.

Wymagania i instalacja

- System: Linux (Ubuntu/Debian/CentOS) lub kontener Docker.

- Jęzki/ramy: PHP, Node.js, Python, Ruby — każdy ma dojrzałe klienty.

- Porty: Redis domyślnie 6379, Memcached 11211.

Instalacja Redis (Ubuntu/Debian)

- apt update && apt install redis-server

- systemctl enable redis-server && systemctl start redis-server

- Plik konfiguracyjny: /etc/redis/redis.conf

Ważne: w produkcji ustaw hasło (requirepass), rozważ bind 127.0.0.1 lub prywatną sieć VPC, oraz włącz trwałość (AOF).

Instalacja Memcached (Ubuntu/Debian)

- apt update && apt install memcached libmemcached-tools

- systemctl enable memcached && systemctl start memcached

- Konfiguracja: /etc/memcached.conf (ustaw -m dla pamięci, -l dla interfejsu)

Wzorzec cache’owania zapytań krok po kroku

- Tworzysz deterministyczny klucz na podstawie zapytania/parametrów.

- Sprawdzasz cache: jeżeli trafienie — zwracasz wynik.

- Jeżeli pudło — pobierasz z bazy, zapisujesz do cache z TTL, zwracasz.

- Inwalidujesz lub odświeżasz wpis, gdy dane źródłowe się zmienią.

Dobra praktyka: unikaj nieograniczonej liczby kluczy (np. nie buduj klucza z nieprzewidywalnych parametrów użytkownika bez normalizacji). Ustal maksymalną długość i prefixy per domena danych: app:products:list:filters:hash

Konfiguracja Redis do cache’owania zapytań

- Dobierz TTL per typ danych (np. listy 60–300 s, szczegóły 300–900 s).

- Używaj prefiksów kluczy: app:category:123:top

- Zdefiniuj politykę wysiedlania (maxmemory-policy): allkeys-lru dla cache’u.

- Unikaj nadmiernie dużych wartości (kompresja JSON opcjonalnie).

Przykład serializacji JSON: wartość przechowuj jako gotowy JSON string. Przy odbiorze waliduj wersję schematu (np. v2:) w prefiksie klucza, co ułatwia przejścia migracyjne.

TTL, unikanie stampede i inwalidacja

- Ustal losowe “jitter” TTL (np. 300–360 s) by uniknąć jednoczesnego wygaśnięcia wielu kluczy.

- Wprowadź lock lub mechanizm single-flight: pierwszy proces odświeża, reszta serwuje stary wynik przez krótki “stale-while-revalidate” (Redis: SET key val EX 300 NX; dodatkowy klucz lock z krótkim TTL).

- Inwalidacja przy zapisie: po modyfikacji produktu usuń app:product:ID oraz app:products:list:* zależne (trzymaj listę zależności lub użyj patternów plus skanowanie SCAN — ostrożnie w produkcji).

Przykłady użycia w popularnych językach

- PHP (predis lub phpredis): pobierz get(key), jeśli null -> zbuduj wynik, setex(key, ttl, json).

- Python (redis-py): r.get, r.setex. Rozważ pipelining dla wielu kluczy.

- Node.js (ioredis/node-redis): get/setEx, connection pooling przez bibliotekę lub domyślnie.

Konfiguracja Memcached do cache’owania zapytań

- Klucze do 250 znaków; wartości do kilkudziesięciu MB (zależnie od build; zalecaj mniejsze).

- Dobierz “-m” (pamięć) i strategię TTL — Memcached sam wyrzuci najstarsze/nieużywane wpisy.

- Hash konsystentny klienta umożliwia skalowanie poziome (kilka nodów).

Dobre praktyki:

- Stałe prefixy i ograniczenie spersonalizowanych wariantów.

- Krótsze TTL przy wysokiej zmienności danych.

- Bulk get (multi-get) dla list widoków.

Sesje użytkowników w Redis

Redis jest domyślnym wyborem do sesji, bo oferuje TTL per klucz i możliwość trwałości.

-

PHP (phpredis):

- session.save_handler = redis

- session.save_path = “tcp://127.0.0.1:6379?auth=twojeHaslo&database=1”

- Opcja session.gc_maxlifetime definiuje TTL; w Redis sesje wygasają automatycznie.

-

Node.js (express-session + connect-redis):

- Store: RedisStore z ioredis; ustaw ttl: 86400, prefix: “sess:”.

- Zabezpiecz cookie (secure, httpOnly, sameSite) i podpisz secret.

-

Python (Django):

- CACHES i SESSION_ENGINE = django.contrib.sessions.backends.cache z backendem redis.

- TTL ustaw przez SESSION_COOKIE_AGE lub per backend.

Wskazówki:

- Ustaw prefix (np. sess:) aby odseparować sesje od reszty kluczy.

- Rozważ AOF (appendonly yes) dla minimalizacji utraty sesji.

- Włącz lazyfree-lazy-eviction w dużych zbiorach, by zmniejszyć pauzy GC.

Sesje użytkowników w Memcached

Memcached świetnie działa, gdy utrata sesji w razie restartu nie jest krytyczna.

-

PHP:

- session.save_handler = memcached

- session.save_path = “127.0.0.1:11211?persistent=1&weight=1&timeout=2&retry_interval=10”

-

Node.js: connect-memcached jako store.

-

Zalecenia: krótsze TTL, sensowne retry i timeouts, monitoring liczby evictions.

Bezpieczeństwo i dostęp sieciowy

- Binduj do prywatnego interfejsu: Redis (bind 127.0.0.1 lub adres VPC), Memcached (-l 127.0.0.1).

- Wymagaj uwierzytelnienia w Redis (requirepass / ACL). Memcached nie ma wbudowanego auth — użyj firewalla lub SASL (w zależności od wdrożenia).

- Ogranicz dostęp portów do aplikacji, nie wystawiaj publicznie.

- Rozważ TLS (stunnel/redis TLS build) dla środowisk z surowymi wymaganiami compliance.

Parametry produkcyjne, które robią różnicę

-

Redis:

- maxmemory i maxmemory-policy (allkeys-lru dla cache).

- appendonly yes + appendfsync everysec (balans trwałości i wydajności) dla sesji.

- tcp-keepalive, timeout, aktywne defragmentowanie w dużych datasetach.

-

Memcached:

- -m (pamięć), -c (max połączeń), -t (wątki), -I (max rozmiar slab), -v tylko do debug.

- Ustal właściwe timeouts po stronie klienta, by unikać “wiszących” żądań.

Monitoring, metryki i testy obciążeniowe

- Metryki Redis: used_memory, evicted_keys, keyspace_hits/misses, connected_clients, instantaneous_ops_per_sec, latency.

- Metryki Memcached: get_hits/misses, curr_items, evictions, bytes, curr_connections.

- Wprowadzaj dashboard (Prometheus + Grafana, Datadog).

- Testuj JMeter/k6/Gatling: sprawdź opóźnienia przy zimnym i ciepłym cache.

- Cel: wysoki hit ratio (70–95% dla typowych list/widoków), niski odsetek evictions.

Typowe błędy i jak ich uniknąć

- Brak inwalidacji po zapisie → serwowanie starych danych. Wzorzec: publish/subscribe do powiadamiania workerów o zmianach lub tagowanie grup kluczy.

- Zbyt długie TTL na bardzo dynamicznych danych → niespójności.

- Jedna ogromna wartość (mega JSON) zamiast mniejszych segmentów → trudna inwalidacja i większe opóźnienia.

- Brak limitów pamięci i polityki eviction → nieprzewidywalne wyrzucanie.

- Niewyłączone publiczne porty → ryzyko bezpieczeństwa.

- Brak backoff/retry w kliencie → kaskadowe błędy przy chwilowych problemach.

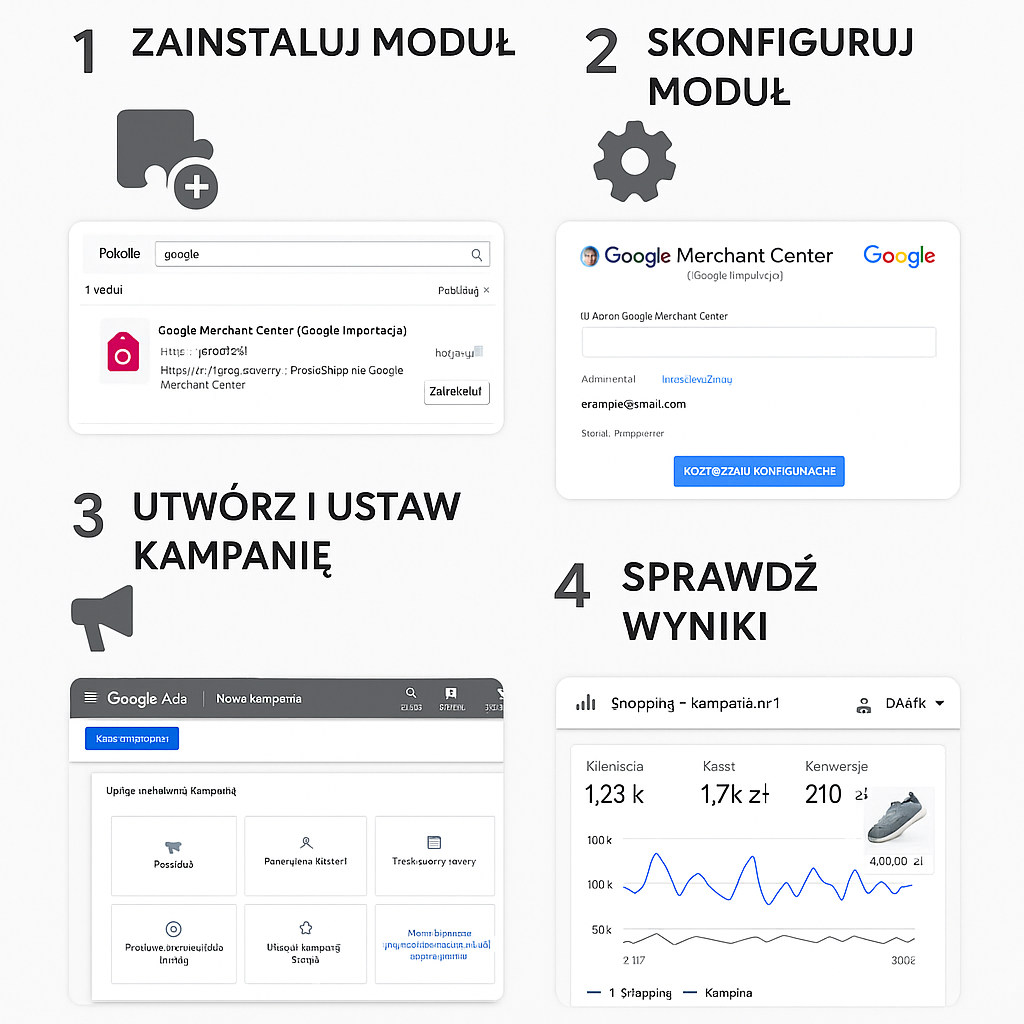

Przykładowy plan wdrożenia krok po kroku

- Zidentyfikuj 3–5 endpointów o największym koszcie (profiling, logi wolnych zapytań).

- Zaprojektuj klucze i TTL (zapisz w README/kontrakcie zespołu).

- Dodaj warstwę cache w kodzie (get → pudło → setex), loguj hit/miss.

- Skonfiguruj sesje w Redis/Memcached i włącz zabezpieczenia.

- Dodaj monitoring metryk cache i alerty.

- Przeprowadź testy obciążeniowe z wypełnionym cache.

- Wdróż stopniowo (canary/feature flag), obserwuj wpływ na bazę i opóźnienia.

- Po tygodniu audyt: dostrój TTL, pamięć, politykę eviction.

Checklist wdrożeniowa Redis/Memcached

- Prefiksy kluczy, deterministyczne klucze, dokumentacja TTL.

- Inwalidacja i ochrona przed cache stampede.

- Ograniczony dostęp sieciowy, hasła/ACL (Redis), firewall (Memcached).

- Monitoring hit/miss, evictions, opóźnień.

- Testy awarii: restart procesu, utrata węzła, przeciążenie.

- Tryb trwałości (Redis) dla sesji krytycznych.

Kiedy który silnik wybrać

- Jeśli sesje są ważne i chcesz opcjonalnej trwałości oraz zaawansowanych operacji: Redis.

- Jeśli potrzebujesz prostego, ultraszybkiego cache’u odczytowego i minimalnego narzutu: Memcached.

- W wielu systemach najlepszy jest miks: sesje i kluczowe mechanizmy w Redis, a masowy cache widoków w Memcached.

Podsumowanie

Dobrze zaprojektowane cache’owanie zapytań i sesji pozwala osiągnąć skok wydajności bez przebudowy całej architektury. Zacznij od najcięższych endpointów, wprowadź klarowne TTL i inwalidację, włącz monitoring i zabezpieczenia. Zarówno Redis, jak i Memcached mają dojrzałe ekosystemy i klienty — wybór zależy od charakteru danych i wymagań biznesowych. Gdy połączysz właściwy dobór narzędzia z dyscypliną operacyjną, uzyskasz spójny, przewidywalny i naprawdę szybki system gotowy na wzrost ruchu.