Google Search Console błędy indeksacji — co naprawdę oznaczają?

Krótko: to sygnał, że Google ma problem z dotarciem, zrozumieniem lub zakwalifikowaniem Twoich stron do indeksu, ale w większości przypadków da się to szybko zdiagnozować i naprawić.

Google Search Console błędy indeksacji to po prostu komunikaty, że wyszukiwarka nie może dodać części Twoich podstron do swojego indeksu lub uznała, że w tej chwili nie powinna. To nie zawsze „wyrok”, a często zaproszenie do porządków: technicznych, treściowych lub związanych z architekturą serwisu. Dobra wiadomość? Większość problemów ma powtarzalne przyczyny i konkretne rozwiązania. Poniżej znajdziesz praktyczny przewodnik, który przeprowadzi Cię od diagnozy do naprawy — bez paniki, bez marnowania budżetu crawl i bez domysłów, co „Google chciało powiedzieć”.

Jak działa indeksowanie w skrócie: crawl → render → index

Zrozumienie tej sekwencji pomaga szybko zlokalizować źródło problemu i dobrać właściwe kroki.

-

Crawl (skanowanie): Googlebot próbuje wejść na stronę, pobrać jej kod i zasoby (JS, CSS, obrazy). Tu „wysypują się” błędy sieciowe, robots.txt, przekierowania, 404 i 5xx.

-

Render: Google stara się złożyć stronę tak, jak widzi ją użytkownik (zwłaszcza jeśli używasz JS). Tu wychodzą na jaw problemy z dynamicznym ładowaniem treści, blokowaniem zasobów i „pustymi” wersjami HTML.

-

Index: algorytmy decydują, czy strona powinna trafić do indeksu. Tu kluczowe są jakość treści, duplikacja, kanoniczność, sygnały z linków i intencja strony.

Szybka diagnostyka w 10 minut

Jeśli potrzebujesz błyskawicznego planu działania — zacznij od tych kroków.

-

Wejdź w raport „Indeksowanie” → „Strony” i spójrz na sekcję „Nieindeksowane”.

-

Zidentyfikuj dominujący typ problemu (np. „Odnaleziono – obecnie nie zindeksowano”, „Zablokowano przez plik robots.txt”, „Soft 404”).

-

Wybierz jedną reprezentatywną URL i użyj „Sprawdź adres URL”.

-

Kliknij „Przetestuj aktywną stronę” (Live test), by zobaczyć stan rzeczywisty, a nie z cache.

-

Sprawdź:

- Status HTTP (200/301/404/5xx).

- Czy meta robots/HTTP header nie zawiera „noindex”.

- Czy robots.txt nie blokuje ścieżki zasobów.

- Jak wygląda „Wyświetl zrenderowaną stronę” (czy treść jest widoczna bez interakcji?).

-

Oceń sygnały kanoniczne (link rel=canonical, linkowanie wewnętrzne, duplikaty parametryczne).

-

Rozszerz diagnozę na grupę stron: użyj filtrów/regex w GSC, by uchwycić wzorce (np. parametry, paginacja, kategorie).

-

Zapisz wnioski i wprowadź poprawki, zaczynając od problemów blokujących (5xx, robots.txt, noindex), potem jakości i kanoniczności.

-

Zgłoś do ponownego indeksowania tylko kluczowe naprawione URL-e.

-

Monitoruj efekty w raporcie i logach serwera przez najbliższe 1–2 tygodnie.

Najczęstsze komunikaty i co z nimi zrobić

Każdy komunikat mówi o innej klasie problemów. Oto praktyczne tłumaczenie „z języka Google” na działania.

„Odnaleziono – obecnie nie zindeksowano” (Discovered, currently not indexed)

Google wie, że strona istnieje, ale nie uznało jej jeszcze za wartą indeksacji.

-

Najczęstsze przyczyny:

- Słaba lub cienka treść (thin content), brak unikalnej wartości.

- Brak linkowania wewnętrznego, „sieroty” (orphan pages).

- Nadmiar bliźniaczo podobnych stron (np. z parametrami).

- Nadmierny przyrost nowych URL-i (ograniczony crawl budget).

-

Co zrobić:

- Wzmocnij treść: dodaj unikalne sekcje, odpowiedzi na pytania użytkowników, multimedia.

- Popraw linkowanie wewnętrzne: z kluczowych hubów prowadź linki do tych URL-i.

- Ogranicz generowanie zduplikowanych adresów (parametry, sortowania).

- Dodaj do mapy witryny tylko URL-e, które chcesz indeksować.

„Przeskanowano – obecnie nie zindeksowano” (Crawled, currently not indexed)

Google odwiedziło stronę, ale zdecydowało się jej nie indeksować. To sygnał jakości/kanoniczności.

-

Przyczyny:

- Duplikacja względem innej strony (ta sama intencja).

- Zbyt ogólna lub powielona treść (np. kopie opisów produktów).

- Niski autorytet URL-a i brak sygnałów wewnętrznych.

-

Rozwiązania:

- Uczyń stronę wyraźnie inną: porównania, opinie, FAQ, schematy danych.

- Dodaj linki z istotnych kontekstów (artykuły poradnikowe, kategorie).

- Zastosuj poprawną kanoniczność, jeśli to wariant/podobny produkt.

„Soft 404”

Strona wygląda jak błąd (pusta, uboga, bez oferty), ale zwraca 200 OK.

-

Przykłady:

- Wyczerpany produkt bez alternatyw.

- Pusta kategoria bez listingu.

- Strona informująca o braku zasobu, lecz 200 zamiast 404.

-

Naprawa:

- Jeśli zasobu nie będzie — zwracaj 404 lub 410.

- Jeśli chwilowo brak — pokaż wartościową treść: rekomendacje, filtry, poradnik.

- Dodaj jasny sygnał indeksacji (unikalna treść + linki), jeśli strona ma istnieć.

„Duplikat bez wskazanego kanonicznego” / „Strona alternatywna z prawidłowym kanonicznym”

Google widzi kilka podobnych wersji i wybiera jedną, często nie tę, którą chcesz.

-

Co sprawdzić:

- rel=canonical (czy prowadzi do właściwej wersji).

- Parametry w URL-ach (sort, filtr, sesja).

- Wersje http/https, www/non-www, trailing slash.

- Tytuły i nagłówki — czy nie są klonami.

-

Działania:

- Ustal jedną wersję kanoniczną i trzymaj się jej konsekwentnie.

- Ogranicz indeksację wariantów parametrycznych (noindex, kanoniczny, blokady w linkowaniu).

- Ujednolić przekierowania 301 między wariantami.

„Wykluczono przez tag noindex”

To intencjonalne wyłączenie z indeksu — sprawdź, czy świadome.

- Jeśli to celowe (np. paginacje, wewnętrzne wyniki wyszukiwania) — zostaw.

- Jeśli nie — usuń noindex z meta/HTTP, pamiętając o cache’u: zmiana może zająć kilka dni.

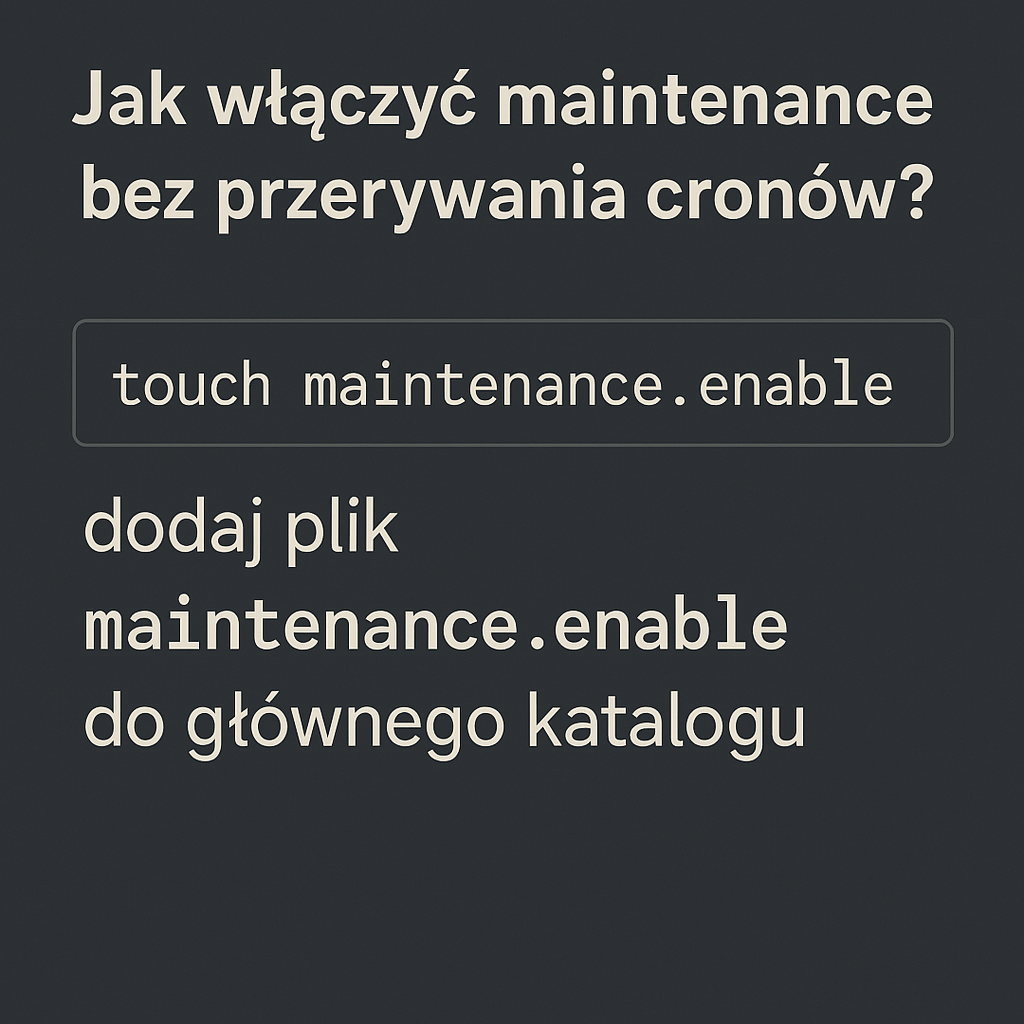

„Zablokowano przez plik robots.txt”

Google nie może zeskanować adresu — sprawdź, czy dotyczy strony czy zasobów.

- Dla stron docelowych zwykle nie blokuj przez robots.txt (to nie narzędzie do wykluczania z indeksu — do tego służy noindex).

- Zasoby krytyczne do renderowania (JS, CSS) nie powinny być blokowane.

- Po zmianach użyj „Testera pliku robots.txt” i Live testu w GSC.

„Błąd przekierowania” / „Strona z przekierowaniem”

Łańcuchy, pętle lub niekonsekwencje utrudniają Google dotarcie do właściwej wersji.

- Zasady:

- Stosuj bezpośrednie 301 tam, gdzie to możliwe (krótki łańcuch).

- Unikaj 302/307 dla stałych zmian.

- Spójność: zawsze https (jeśli masz), zawsze www lub non-www, jeden wariant ze slash.

„Nie znaleziono (404)” i „Usunięto (410)”

Błędy są normalne, o ile są uzasadnione i nie masowe.

-

Kiedy 404/410 jest OK:

- Produkt/permalink usunięty bez zamiennika.

- Tymczasowe linki testowe, błędy literowe w linkach zewnętrznych (opcjonalnie 301 do najbardziej podobnej strony).

-

Dobre praktyki:

- Strona 404 powinna zawierać nawigację, wyszukiwarkę i propozycje.

- 410 oznacza trwałe usunięcie — przyspiesza wyindeksowanie.

„Błąd serwera (5xx)” / „Zbyt wiele żądań (429)”

Problemy infrastrukturalne, które bezpośrednio hamują indeksację.

- Co zrobić:

- Sprawdź logi serwera (piki obciążenia, blokady firewall/WAF).

- Włącz cache, zoptymalizuj zapytania do bazy.

- Pozwól Googlebotowi na crawl (nie blokuj jego UA ani zakresów IP).

- Rozważ CDN i autoskalowanie, jeśli ruch jest nieregularny.

„Anomalia podczas indeksowania” (Crawl anomaly)

Ogólny, „parasolowy” błąd — zwykle niestabilne odpowiedzi serwera.

- Diagnostyka:

- Porównaj czasy odpowiedzi, statusy w logach, powtórz Live test.

- Sprawdź, czy reguły bezpieczeństwa nie blokują Googlebota warunkowo (np. rate limiting).

Jak naprawiać problemy krok po kroku (proces, który działa)

Zamiast „strzelać” zmianami, zastosuj powtarzalny workflow — oszczędzisz czas i zasoby.

- Zmapuj skalę problemu

- Zidentyfikuj typ błędu dominujący i grupy URL-i (kategorie, tagi, parametry, paginacja).

- Użyj eksportu z GSC i prostych etykiet, by zrozumieć, co naprawdę „boli”.

- Ustal priorytety

- Najpierw błędy blokujące (5xx, robots, noindex), potem kwestie jakości i kanoniczności.

- Priorytetyzuj strony o największym potencjale ruchu/konwersji.

- Wprowadź poprawki w małych partiach

- Testuj na wycinku (np. jedna kategoria), porównaj efekty po 7–14 dniach.

- Zapisuj zmiany (data, opis), by korelować z danymi w GSC.

- Zgłaszaj do ponownego indeksowania selektywnie

- Proś o indeksację tylko dla stron kluczowych lub po istotnych zmianach.

- Dla masowych aktualizacji używaj sitemapy (lastmod) zamiast spamowania narzędzia.

- Monitoruj i iteruj

- Śledź wykresy „Prawidłowe” vs „Wykluczono” oraz pokrycie mapy witryny.

- Jeśli brak poprawy — pogłęb analizę: logi, render, testy zewnętrzne (Lighthouse, Screaming Frog + render JS).

JavaScript, renderowanie i indeksacja

Jeśli treść „pojawia się dopiero po chwili” albo „po kliknięciu”, Google może jej nie zobaczyć.

-

Wyzwania:

- CSR (Client-Side Rendering) bez SSR/rehydration może zostawić Google pusty HTML.

- Blokowane zasoby JS/CSS uniemożliwiają złożenie strony.

- Lazy loading, który ukrywa treść bez scrolla.

-

Rozwiązania:

- Rozważ SSR/ISR/Hybrid (Next.js, Nuxt, Astro) lub prerendering krytycznych podstron.

- Upewnij się, że kluczowy content znajduje się w HTML po załadowaniu lub w pierwszym renderze.

- Zadbaj o atrybuty loading i noscript dla obrazów.

- Nie blokuj JS/CSS w robots.txt; minimalizuj zależności i czas wykonywania.

Mapa witryny i sygnały kanoniczne

Sitemap to „plan miasta” dla Google — ale tylko, jeśli jest czysta i aktualna.

-

Dobre praktyki mapy witryny:

- Tylko URL-e, które mają trafić do indeksu i zwracają 200.

- Aktualne lastmod po rzeczywistej zmianie treści.

- Rozbij duże mapy (do 50 tys. URL albo 50 MB nieskompresowane).

- Oddziel mapy: treści, produkty, blog, wideo, obrazy.

-

Kanoniczność:

- Spójność rel=canonical, przekierowań, linkowania i mapy (wszystko wskazuje na tę samą wersję).

- Unikaj kanonicznych do stron z parametrami lub do paginacji (chyba że to świadome).

- Gdy stron jest wiele o tej samej intencji — wybierz jedną kanoniczną i wzmocnij ją linkami.

Architektura i linkowanie wewnętrzne

Google podąża za linkami. Im łatwiej dotrzeć do danej strony, tym szybciej ją przeskanuje i zindeksuje.

- Zasady:

- Priorytetowe URL-e powinny być dostępne w 2–3 kliknięciach z głównych hubów.

- Stosuj kontekstowe linki w treści, nie tylko w menu.

- Używaj opisowych anchorów — pomagają zrozumieć temat strony.

- Uporządkuj paginację i unikaj nieskończonych kombinacji filtrów (faceted navigation).

Treść, jakość i intencja

„Nieindeksowane” często oznacza „niewystarczająco dobre” na tle konkurencji.

-

Wzmacnianie jakości:

- Pokaż doświadczenie i ekspertyzę (E‑E‑A‑T): autorzy, źródła, dane, case studies.

- Odpowiadaj na konkretne pytania użytkowników (sekcje FAQ, poradniki).

- Dodaj elementy unikalne: porównania, tabele korzyści, zdjęcia własne, wideo.

- Ujednolić template’y, ale treść niech będzie zindywidualizowana.

-

Higiena:

- Usuń lub scal cienkie podstrony (przekierowania 301).

- Zapobiegaj duplikacji (tagi, tagi UTM w linkach wewnętrznych, parametry sortowania).

Specjalne przypadki: produkty, blog, filtry, języki

Różne typy stron wymagają innej strategii indeksacji.

-

Produkty:

- Wyczerpane? Jeśli wrócą — zostaw 200 z alternatywami; jeśli nie — 404/410 lub 301 do następcy.

- Dane strukturalne (Product, Offer) poprawiają zrozumienie i CTR.

-

Blog i poradniki:

- Klastrowanie tematów (topic clusters) i huby tematyczne.

- Aktualizacje starszych treści (lastmod + realna zmiana).

-

Filtry i sortowanie:

- Z reguły noindex lub kanoniczne do wersji bazowej, chyba że dany filtr ma wysoki popyt i unikalny listing.

-

Paginacja:

- rel=prev/next nie jest już używane do kanoniczności; zadbaj o logiczne linkowanie i indeksuj tylko strony z realną wartością.

-

Wersje językowe i hreflang:

- Spójne pary hreflang między wariantami.

- Kanoniczne wewnątrz języka, nie między językami.

„Poproś o indeksację” — kiedy używać z głową

To narzędzie jest pomocne, ale nie zastąpi silnych sygnałów jakości i linkowania.

-

Używaj, gdy:

- Naprawiłeś błąd blokujący (noindex, 5xx, błędne przekierowania).

- Dodałeś nową, wartościową stronę (kluczowy materiał, produkt, landing).

- Zaktualizowałeś znacząco treść.

-

Unikaj:

- Masowego „pingowania” setek URL-i.

- Zgłaszania stron o marnej jakości — to nie pomoże.

Google Search Console błędy indeksacji a monitoring i zapobieganie

Stały monitoring to mniej pożarów i stabilniejszy ruch z SEO.

-

Co wdrożyć:

- Alerty e-mail w GSC dla gwałtownych zmian.

- Cotygodniowy przegląd raportu „Strony” i mapy witryny.

- Analiza logów serwera (kto odwiedza, jakie statusy, jak często Google wraca).

- Adnotacje (notatki) przy wdrożeniach, by łatwo łączyć zdarzenia z wynikami.

-

Narzędzia pomocnicze:

- Screaming Frog/Website Auditor z renderem JS.

- PageSpeed/Lighthouse dla oceny renderu i stabilności.

- Monitor uptime (5xx) i Web Application Firewall ustawiony tak, by nie mylił Googlebota z botami spamowymi.

Checklista szybkiej oceny (do powieszenia obok monitora)

Skup się na podstawach, zanim wejdziesz w niuanse — to one najczęściej rozwiązują 80% problemów.

-

Statusy HTTP: 200 tam, gdzie trzeba; 301 dla stałych przekierowań; 404/410 dla usuniętych.

-

Robots i noindex: nic ważnego nie jest blokowane; noindex tylko tam, gdzie celowo.

-

Kanoniczność: jedna, spójna wersja; brak sprzecznych sygnałów.

-

Mapa witryny: tylko indeksowalne URL-e; lastmod odzwierciedla realne zmiany.

-

Treść: unikalna, kompletna, odpowiadająca intencji; sekcje FAQ i multimedia mile widziane.

-

Linkowanie wewnętrzne: priorytetowe strony w 2–3 kliknięciach; sensowne anchory.

-

Render JS: kluczowa treść widoczna dla Google; brak blokad zasobów.

-

Logi serwera: brak masowych 5xx/429; Googlebot nie jest ograniczany.

-

Parametry i filtry: nie tworzą lawiny duplikatów; wdrożone reguły kanoniczności/noindex.

-

Zgłoszenie do indeksu: tylko po realnych naprawach lub dla stron kluczowych.

Przykłady decyzji w trudnych sytuacjach

Krótka ściąga pokazująca, jak myśleć w różnych scenariuszach.

-

Masz tysiące stron „Odnaleziono, ale nie zindeksowano”?

- Skup się na jakości i linkowaniu. Usuń z mapy witryny to, czego nie chcesz indeksować. Oceń, czy część stron nie powinna zostać scalona.

-

Masowe „Soft 404” w kategoriach?

- Zadbaj, by pusty listing pokazywał alternatywy, filtry i treść poradnikową. Jeśli kategoria nie ma racji bytu — 404/410 lub noindex i przekierowanie.

-

Duplikaty przez parametry?

- Ustal jasne zasady: kanoniczne do wersji bazowej, noindex dla większości kombinacji, blokada generowania linków do nieistotnych wariantów.

-

Strony JS bez SSR?

- Wdróż prerender/SSR dla stron o wysokiej wartości lub zastosuj hybrydę. Sprawdź, co widzi Google w „Wyświetl zrenderowaną stronę”.

Czego nie robić, nawet jeśli kusi

Unikniesz cofek i kolejnych problemów.

- Nie dawaj noindex stronom, które chcesz pozycjonować „na chwilę”, żeby „zobaczyć co będzie”.

- Nie blokuj w robots.txt wersji produkcyjnej zasobów potrzebnych do renderu.

- Nie licz, że samo „Poproś o indeksację” rozwiąże problem niskiej jakości treści.

- Nie twórz setek podobnych stron na te same frazy — Google wybierze jedną, reszta zostanie wykluczona.

FAQ — krótkie odpowiedzi na częste pytania

Zebrane najczęstsze wątpliwości, żebyś nie musiał szukać dalej.

-

Ile trwa ponowne indeksowanie po naprawie?

- Zwykle od kilku godzin do kilkunastu dni. Strony o wyższym autorytecie wracają szybciej.

-

Czy warto usuwać stare, słabe treści?

- Tak, jeśli nie konwertują i nie mają potencjału — lepiej scalić lub zaktualizować niż trzymać „cieniznę”.

-

Czy sitemapa przyspieszy indeksację?

- Pomaga w odkrywaniu, ale nie zastąpi jakości. Sitemapa powinna być czysta i aktualna.

-

Co z rel=prev/next?

- Google już tego nie używa do kanoniczności. Skup się na sensownym linkowaniu i indeksowaniu tylko wartościowych stron paginacji.

-

Czy Indexing API pomoże?

- Tylko dla określonych typów treści (oferty pracy, wydarzenia z livestream). Dla zwykłych stron — nie.

Podsumowanie: uporządkowany proces zamiast nerwowych ruchów

Najpierw diagnoza, potem szybkie, celne poprawki i spokojny monitoring.

Gdy widzisz w raporcie komunikaty o wykluczeniach, potraktuj je jak mapę, a nie wyrok. Rozbij problem na etapy: technika (statusy, robots, render), sygnały (kanoniczność, linkowanie, sitemapa), jakość (treść, intencja), a na koniec — rozsądne zgłoszenie do indeksacji i monitoring. Z takim podejściem nawet duże „czerwone” wykresy w Google Search Console zaczną zielenieć, a Twoje strony wrócą na właściwe tory bez zbędnych eksperymentów.