PrestaShop brak indeksacji Google to problem, który potrafi spędzić sen z powiek właścicielom sklepów internetowych – produkty są dodane, wszystko działa, a mimo to w wyszukiwarce pusto albo pojawia się tylko część asortymentu. Przyczyny bywają techniczne, treściowe i organizacyjne. Dobra wiadomość: w zdecydowanej większości przypadków da się je szybko zdiagnozować i naprawić.

Wprowadzenie do problemu

Dlaczego produkty nie trafiają do indeksu i jak podejść do tego metodycznie.

Brak obecności stron produktów w wynikach wyszukiwania rzadko jest „karą” od Google. Najczęściej to konsekwencja sygnałów, które algorytmy czytają dosłownie: tagi noindex, zablokowany dostęp w robots.txt, błędne linkowanie wewnętrzne, duplikacja adresów, niepoprawna mapa witryny albo problemy serwerowe. W e‑commerce, gdzie liczy się skala i automatyzacja, wystarczy jeden checkbox lub moduł zmieniający meta tagi, by setki stron przestały być kwalifikowane do indeksu. W tym tekście znajdziesz kompletną listę przyczyn, narzędzi diagnostycznych i procedur naprawczych – z podziałem na ustawienia PrestaShop, serwer oraz treść.

Jak działa indeksacja Google w praktyce

Trzy etapy: odkrywanie, crawling, indeksowanie – i gdzie najczęściej powstaje blokada.

Aby produkt mógł pojawić się w wynikach:

- Google musi odkryć URL (np. przez link wewnętrzny, mapę witryny, link zewnętrzny).

- Robot musi go pobrać (crawl), bez przeszkód typu auth, 403/404, zbyt niska szybkość serwera.

- Algorytm musi uznać, że warto go zindeksować (brak noindex, odpowiednia treść, kanoniczność).

Kluczowe sygnały:

- robots.txt: steruje dostępem do crawlowania, nie do samego indeksowania – ale jeśli blokujemy crawling, Google nie zobaczy meta robots.

- Meta robots i nagłówki X‑Robots‑Tag: mogą nakazać noindex, nofollow dla stron lub plików.

- Canonical: wskazuje preferowaną wersję, ale nie jest twardym nakazem – Google może ją zignorować, jeśli sygnały są sprzeczne.

- Mapa witryny: pomaga w odkrywaniu i priorytetyzacji, ale nie gwarantuje indeksacji.

- Internal linking: jeśli do produktu nie prowadzi żaden link (sierota), jego odkrycie bywa opóźnione lub niemożliwe.

Najczęstsze przyczyny: PrestaShop brak indeksacji Google

Lista błędów, które najczęściej wyłączają produkty z widoku wyszukiwarki.

- Tagi noindex/nofollow na produktach lub kategoriach, dodane przez motyw lub moduł SEO.

- Disallow w robots.txt dla katalogów z produktami, filtrami, zasobami JS/CSS niezbędnymi do renderowania.

- Zła mapa witryny: brak produktów w sitemap, linki do URL-i 404/302, linki kanoniczne niezgodne z mapą, duplikaty wersji językowych.

- Canonical wskazujący na inną stronę (np. wariant produktu, strona kategorii), przez co Google pomija wersję aktualnie przeglądaną.

- Niespójne parametry w URL (paginacja, sortowanie, filtry) bez kanonicznych adresów – generowanie tysięcy prawie identycznych stron rozprasza crawl budget.

- Tryb konserwacji (503) lub podstawowa autoryzacja (401) aktywna na środowisku produkcyjnym.

- Produkty nieaktywne lub ustawione jako „Widoczność: nigdzie” – Google ich nie odkryje przez linkowanie.

- Powolny serwer, liczne błędy 5xx, limity w WAF/CDN – robot porzuca crawl.

- Zbyt uboga treść (thin content), strony widziane jako mało wartościowe lub „miękki 404”.

- Blokada zasobów renderujących (JS/CSS) – Google nie widzi kluczowych elementów strony.

- Błędne hreflang w wersjach wielojęzycznych, prowadzące do kanibalizacji lub ignorowania części wariantów.

- Duplikacja przez wielokrotne ścieżki do tego samego produktu (np. różne kategorie w URL) bez poprawnego kanonicznego.

- Produkty tymczasowo wyłączone, oznaczone jako niedostępne z noindex przez moduł – wracają, ale meta tag pozostaje.

- Parametry śledzące (utm, gclid) utrwalone w linkach wewnętrznych – powielają adresy i mylą canonicale.

Diagnostyka krok po kroku

Praktyczny workflow od szybkiego sprawdzenia po pełny audyt.

- Szybki test widoczności:

- site:domena.pl nazwa produktu – czy jakiekolwiek produkty są widoczne? Jeśli nie, problem jest systemowy.

- site:domena.pl inurl:/produktowy-slug – sprawdź konkretny URL.

- Google Search Console:

- Inspekcja adresu URL: pobierz zindeksowaną i aktualną wersję, sprawdź status „Strona nie jest zaindeksowana” i powód (noindex, duplikat, alternatywa z odpowiednim kanonicznym, wykryto – obecnie nie zindeksowano, itp.).

- Raport Indeks > Strony: jakie są najczęstsze przyczyny wykluczeń?

- Raport Mapy witryn: ile adresów z sitemapy jest faktycznie zaindeksowanych?

- Ustawienia: zweryfikuj preferowaną domenę (www vs bez www), domeny/lokalizacje w przypadku multistore.

- Źródło strony i nagłówki:

- Sprawdź meta robots w kodzie (index/follow).

- Sprawdź link rel=“canonical”.

- Pobierz nagłówki HTTP (200, 301, 302, 404, 410, 503).

- Zobacz, czy nie ma X‑Robots‑Tag: noindex w nagłówkach.

- Robots.txt:

- Wejdź na /robots.txt i sprawdź, czy nie ma Disallow na katalogi z produktami lub globalnego disallow dla User-agent: *.

- Przetestuj w GSC (tester robots) dostęp dla konkretnego adresu.

- Renderowanie:

- Użyj funkcji „Sprawdź stronę na żywo” w GSC, zobacz zrenderowany HTML.

- Sprawdź konsolę błędów (Resource blocked, 403, 404 dla zasobów JS/CSS).

- Linkowanie wewnętrzne:

- Czy produkt jest dostępny z kategorii, bestsellerów, nowości?

- Czy nie jest sierotą (orphan page)? Skaner typu Screaming Frog pokaże liczbę linków wewnętrznych.

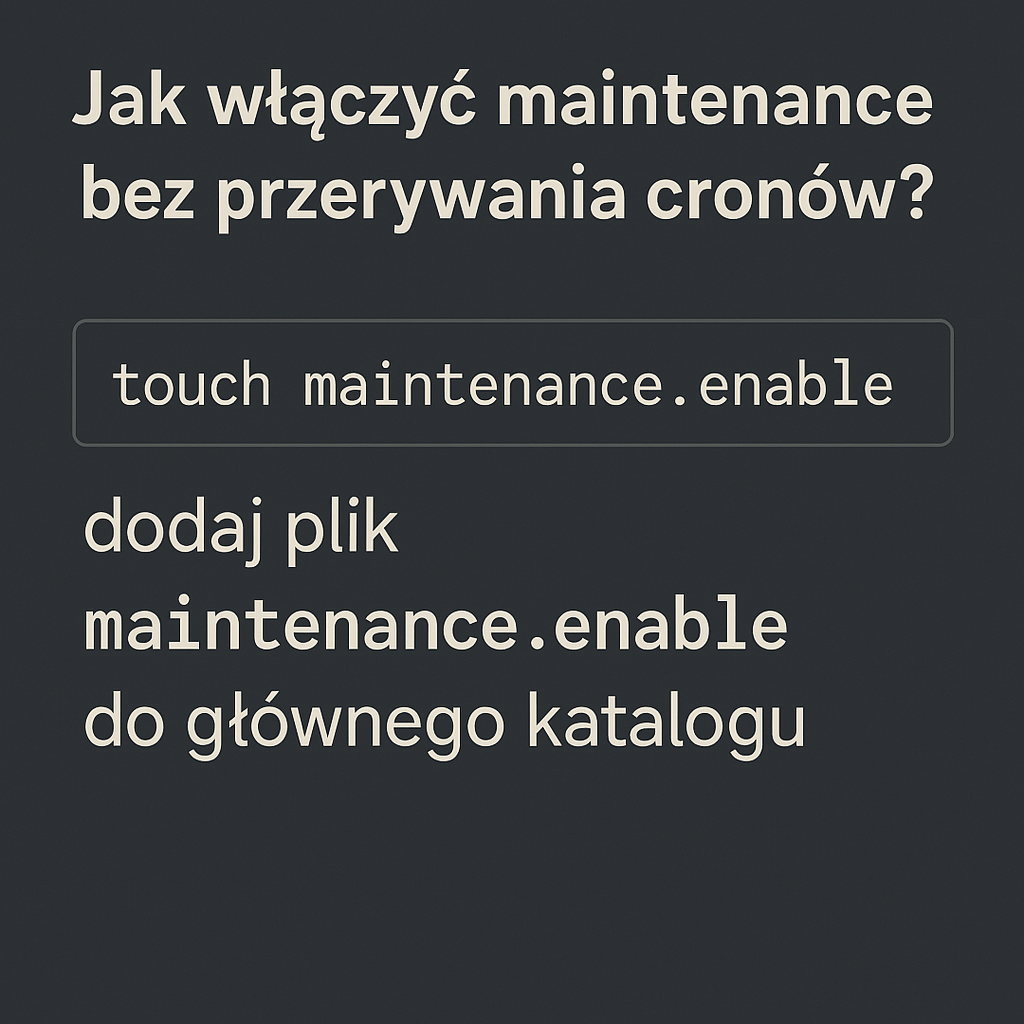

- Ustawienia PrestaShop:

- Shop Parameters > Traffic & SEO: Friendly URL, Canonical redirection (zalecane 301), generowanie robots.txt.

- Ustawienia produktu: Aktywny, Widoczność (najlepiej „wszędzie”), Dostępny do zamówienia (dla zachowania logiki sklepu).

- Moduły SEO: czy nie wstrzykują noindex na „out of stock” lub „price hidden”?

- Moduł mapy witryny: czy generuje produkty i właściwe wersje językowe?

- Logi serwera i CDN:

- Sprawdź limity, reguły firewall, rate limiting dla Googlebot.

- Zobacz, czy robot nie dostaje 403/429.

Ustawienia PrestaShop, które mogą blokować indeksację

Gdzie w panelu zwykle kryją się „przełączniki ryzyka”.

- Shop Parameters > Traffic & SEO:

- Friendly URL: włączone – czyste adresy są lepsze dla crawl.

- Canonical redirection: ustaw 301 (stałe przekierowanie).

- Generowanie robots.txt: wygeneruj i sprawdź zawartość.

- Schemat adresów: przemyśl, czy URL produktu nie powinien być bez kategorii (redukuje duplikację w wielu kategoriach).

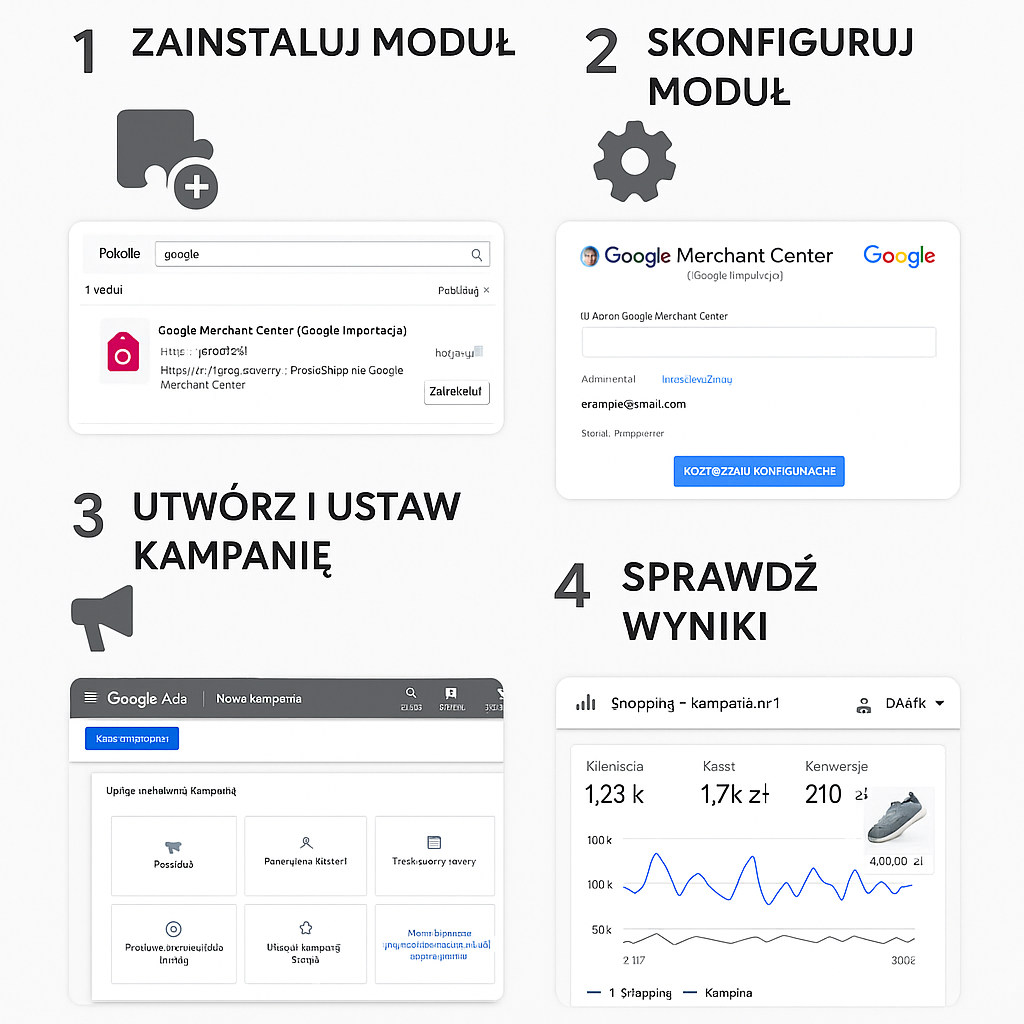

- Tryb konserwacji:

- Shop Parameters > General > Maintenance: na produkcji musi być wyłączony.

- Produkty:

- Widoczność: „wszędzie” – inaczej produkt może nie mieć wejść z kategorii.

- Stan: Produkt aktywny.

- Kombinacje i warianty: unikaj tworzenia osobnych URL dla każdej kombinacji, jeśli treść jest identyczna – używaj canonicala do wersji głównej.

- Moduły:

- ps_google_sitemap (lub analogiczny): configure częstotliwość generowania, włącz produkty, kategorie, wersje językowe, site map index.

- Moduły filtrowania (Faceted Search): motywy i moduły często dodają parametry w URL – upewnij się, że strona podstawowa kategorii ma canonical bez parametrów.

- Moduły „noindex”: niektóre dają możliwość oznaczania wybranych typów stron – sprawdź, czy nie obejmują produktów lub kategorii.

Friendly URL i canonical w PrestaShop

Eliminuj duplikację i ustaw jedną preferowaną wersję adresu.

W PrestaShop ten sam produkt może występować pod różnymi ścieżkami, np. przez różne kategorie nadrzędne. Dlatego:

- Włącz canonical redirection 301 – wymusisz jedną wersję URL.

- Sprawdź, czy motyw nie nadpisuje rel=“canonical”.

- Jeśli produkt może być w wielu kategoriach, rozważ schemat URL bez kategorii (tylko /id‑nazwa.html), co ogranicza mnożenie adresów.

- Unikaj dopisywania parametrów w linkach wewnętrznych (utm, sortowanie). Do kanonicznych linków prowadź bez parametrów.

robots.txt: generowanie i dobre praktyki

Blokuj to, co trzeba – nie blokuj zasobów potrzebnych do renderowania i produktów.

- Nie blokuj /img/, /themes/, /modules/ w sposób, który uniemożliwia renderowanie layoutu.

- Zwykle warto blokować: strony koszyka, logowania, konta, wyszukiwarki wewnętrznej i parametry sortowania/filtrów – ale tylko jeśli zapewnisz canonical do wersji bezparametrowej.

- Po wygenerowaniu pliku w panelu PrestaShop, przejrzyj go ręcznie. Automatyka bywa zbyt agresywna.

- Jeśli korzystasz z CDN, upewnij się, że robots.txt jest spójny na wszystkich wariantach domeny.

Parametry filtrów i nawigacja fasetowa

Minimalizuj indeksowanie „szumu”, wzmacniaj strony kategorii.

- Strony z parametrami (np. ?color=, ?size=) najczęściej powinny mieć canonical do głównej kategorii.

- Unikaj noindex + disallow jednocześnie – jeśli zablokujesz crawl, Google nie odczyta noindexa.

- W module filtrowania poszukaj opcji wpływających na meta robots – testuj na kilku przykładowych filtrach.

Wielojęzyczność i multistore

Hreflang, separacja wersji językowych i kanoniczność.

- Każda wersja językowa powinna mieć własny, samokanoniczny URL oraz kompletny zestaw hreflang wskazujący alternatywy.

- Nie kanonikalizuj PL do EN ani odwrotnie – to inne strony.

- W multistore upewnij się, że mapa witryny i GSC są skonfigurowane dla każdego sklepu/domeny osobno.

Tryb konserwacji i autoryzacja

Błędy 401/403/503 potrafią „wyczyścić” indeks szybciej, niż myślisz.

- 503 Maintenance to dobry sygnał krótkoterminowy, ale jeśli trwa dniami i bez Retry‑After, Google ograniczy crawl.

- Basic Auth (prompt do logowania) na produkcji praktycznie odcina roboty – dla Googlebot to 401 i brak dostępu.

- Firewalle aplikacyjne z regułami anty‑bot mogą dusić Googlebota – sprawdź logi.

Problemy po stronie serwera i wydajność

Crawl budget kocha szybkość i stabilność.

- Niska przepustowość, wolny TTFB, wiele 5xx – robot zmniejsza liczbę odwiedzin.

- Błędy TLS, niestabilny DNS – opóźniają pobieranie.

- Nadmierne przekierowania (łańcuchy 301/302) – zjadają budżet.

- Testuj w Lighthouse i PageSpeed Insights, ale kluczowe są logi serwera: liczba hitów Googlebota, statusy, czas odpowiedzi.

Treść i dane strukturalne produktu

Jakość strony decyduje, czy robot uzna ją za wartą indeksu.

- Unikatowe opisy produktów, zdjęcia, atrybuty – unikaj kopiowania z hurtowni.

- Widoczna cena, dostępność, informacja o dostawie – to minimalny „info scent”.

- Dane strukturalne Product (JSON‑LD): name, image, sku, offers, availability. Błędy w schema nie blokują indeksacji, ale sygnały kompletności pomagają.

- Thin content i duplikacja wariantów: lepiej jedna mocna strona z wyborem wariantu niż 10 niemal identycznych URL-i.

Sitemapy w PrestaShop: konfiguracja i pułapki

Mapa witryny ma pomagać, nie szkodzić.

- Upewnij się, że:

- W sitemap są tylko adresy 200 OK, bez noindex i bez 302.

- Dla wersji wielojęzycznych generowane są osobne bloki/URL-e.

- Aktualizuje się automatycznie (CRON) po dodaniu produktów.

- Nie zawiera duplikatów tego samego produktu pod różnymi ścieżkami.

- W GSC zgłoś indeks map (sitemap index), jeśli masz ich kilka (produkty, kategorie, CMS).

Plan naprawczy krok po kroku

Od najłatwiejszych poprawek po prace programistyczne.

- Usuń blokady:

- Wyłącz tryb konserwacji i autoryzację na produkcji.

- Napraw robots.txt: usuń Disallow dla produktów i zasobów niezbędnych do renderu.

- Uporządkuj meta robots i canonical:

- Usuń noindex z produktów i kategorii, gdzie ma być indeks.

- Ustaw samokanoniczne canonicale (lub do głównej wersji produktu).

- Dla stron z parametrami ustaw canonical do wersji bez parametrów.

- Zadbaj o linkowanie wewnętrzne:

- Z kategorii prowadź linki do wszystkich kluczowych produktów.

- Dodaj bloki „bestsellery”, „nowości”, „ostatnio oglądane”, by zwiększyć odkrywalność.

- Popraw jakość stron:

- Dodaj unikalne opisy, sekcje Q&A, tabelę wymiarów, galerie.

- Uzupełnij dane strukturalne Product.

- Sitemapy:

- Przegeneruj je, usuń złe adresy, podziel na mniejsze pliki (np. po 10–20 tys. URL-i).

- Wydajność i stabilność:

- Skróć TTFB (cache, opcache, HTTP/2/3), usuń łańcuchy 301.

- Skonfiguruj CDN uważnie, bez blokowania Googlebota.

- Zgłoszenie do indeksu:

- W GSC użyj „Poproś o zaindeksowanie” dla kluczowych produktów/kategorii.

- Monitoruj w raporcie Indeks > Strony postęp przez 2–6 tygodni.

Checklista szybkiej kontroli

Najważniejsze punkty do odhaczenia w godzinę.

- Czy produkt daje 200 OK i ma meta robots index, follow?

- Czy rel=“canonical” wskazuje na sam siebie lub właściwą wersję?

- Czy jest widoczny w sitemap i ma link z kategorii?

- Czy robots.txt nie blokuje ścieżki produktu i zasobów renderujących?

- Czy nie ma łańcuchów 301? Czy wersja www/https jest spójna?

- Czy strona nie jest sierotą?

- Czy produkt nie jest „Widoczność: nigdzie” w panelu?

- Czy nie ma aktywnego trybu konserwacji/Basic Auth?

- Czy GSC nie pokazuje „Strona wykryta, obecnie niezaindeksowana” w dużej skali (wskazuje na jakość/zasoby)?

Przypadki szczególne: niedostępność, warianty, paginacja

Decyzje techniczne, które robią wielką różnicę.

-

Produkty chwilowo niedostępne:

- Nie usuwaj stron ani nie dawaj noindex.

- Pokaż „powiadom o dostępności”, alternatywy, zachowaj 200 OK i dane structured data z availability=OutOfStock.

-

Produkty trwale wycofane:

- Jeśli masz następcę – 301 do najbliższego odpowiednika.

- Jeśli brak następcy – 410 Gone (Google szybciej czyści indeks).

- Zachowaj użytkowe strony kategorii bez „martwych” listingów.

-

Wariantu kolor/rozmiar:

- Jedna strona produktu z wyborem wariantu, jedna kanoniczna.

- Parametry w URL do trackingu – z noindex i canonicalem do podstawy lub bez indeksacji.

-

Paginacja kategorii:

- Nie kanonikalizuj strony 2, 3, 4… do strony 1.

- Samokanoniczne dla każdej strony, solidne linkowanie next/prev (mimo że Google nie używa rel next/prev rankingowo, pomaga UX i robotom).

- Rozważ „pokaż wszystko” tylko jeśli wydajność na to pozwala.

Narzędzia do analizy i monitoringu

Co mieć pod ręką, by diagnozy trwały minuty, nie dni.

- Google Search Console: inspekcja URL, indeks, mapy witryn, narzędzia do robots.

- Screaming Frog/ Sitebulb: crawling, meta, canonicale, wykrywanie sierot.

- Log analyzers (np. GoAccess, Splunk): realne wejścia Googlebota i statusy.

- PageSpeed Insights, Lighthouse: wydajność i renderowanie.

- curl, httpie: szybkie sprawdzenie nagłówków i statusów.

- Serp API lub ręczne site: do monitoringu widoczności.

- Monitoringi uptime (UptimeRobot, Better Uptime): wychwytują 5xx.

Mity, które utrudniają pracę

Oddziel fakty od „SEO‑legend”.

- „Mapa witryny gwarantuje indeksację.” – Nie, tylko pomaga w odkryciu.

- „Core Web Vitals decyduje o indeksie.” – Nie bezpośrednio; wpływa na doświadczenie i pośrednio na crawl.

- „Noindex i Disallow razem są lepsze.” – Jeśli zablokujesz crawl, robot nie zobaczy noindex.

- „Paginację najlepiej kanonikalizować do strony 1.” – To kasuje produkty z dalszych stron z indeksu.

- „Duplikacja przez parametry to drobiazg.” – Może zjeść cały crawl budget dużego sklepu.

- „Strona z małą ilością tekstu też się zaindeksuje.” – Może, ale częściej trafi do „wykryto – obecnie niezaindeksowano”.

Prewencja: utrzymywanie zdrowej indeksacji

Stałe procesy i dobre praktyki zespołowe.

- Checklisty wydawnicze: przed wdrożeniem sprawdzaj meta robots, canonicale, robots.txt.

- Monitoring GSC co tydzień: zwłaszcza raport „Strony wykluczone”.

- CRON dla sitemap i ping do Google po generacji.

- QA linkowania: nowe kategorie i produkty muszą mieć linki z menu/listingów.

- Audyt modułów: po aktualizacjach motywu/modułów testuj wpływ na meta i canonical.

- Wydajność: CDN, cache, stabilny hosting – te inwestycje zwracają się w crawl budget.

FAQ: najczęstsze pytania

Krótkie odpowiedzi na dylematy właścicieli sklepów.

-

Ile trwa wejście produktu do indeksu?

- Od kilku godzin do kilku tygodni. Nowe domeny i duże sklepy bez linków wewnętrznych czekają dłużej.

-

Czy mogę wymusić indeksację?

- Nie. Możesz przyspieszyć: linkowaniem wewnętrznym, poprawną sitemapą i zgłoszeniem w GSC.

-

Czy PrestaShop ma „przycisk” włączający indeksację?

- Nie. Indeksacja to suma sygnałów technicznych i jakościowych. Panel daje narzędzia, ale nie „magiczny przełącznik”.

-

Czy błędy w schema blokują indeksację?

- Nie, ale utrudniają bogate wyniki i wiarygodność strony.

-

Czy lepiej migrować na inną platformę?

- Zwykle nie ma takiej potrzeby. 90% problemów indeksacyjnych to konfiguracja, nie platforma.

-

Czy wersja 1.6/1.7/8 ma znaczenie?

- Starsze wersje częściej mają problemy z wydajnością i modułami, ale zasady indeksacji są te same.

-

Czy blokować filtry w robots.txt?

- Raczej stosować canonical do wersji bez parametrów. Blokada crawla bez canonical może utrudnić robotom zrozumienie struktury.

Podsumowanie i następne kroki

Najpierw usuń blokady, potem wzmocnij sygnały i poczekaj na efekt.

Jeśli zmagasz się z niewidocznością produktów, zacznij od podstaw: wyłącz wszelkie blokady (noindex, disallow, maintenance), ustaw poprawne canonicale, upewnij się, że mapa witryny zawiera aktualne adresy 200 OK, a strony produktów są dobrze podlinkowane z kategorii. Sprawdź stabilność serwera i przyspiesz TTFB. Dodaj unikatowe, wartościowe treści i pełne dane strukturalne. Po naprawach zgłoś kluczowe adresy w Google Search Console i monitoruj status przez kilka tygodni. Konsekwencja w procesach i regularny przegląd raportów GSC sprawią, że problem nie wróci – a w miarę rozwoju sklepu indeksacja będzie przebiegać płynnie i przewidywalnie.